前言

导语

随着现在人工智能(AI)技术的兴起,大部分 AI 都具备了文生图/图生图的能力。

Stable Diffusion 简称 SD(下文都将使用简称替代)。SD 是一款免费且开源的 AI 作图工具,同时有着大佬 秋叶aaaki的整合包,生态还算不错。

说到生态,对于 LoRA(一种微调模型训练方法,下文会详细讲)或者模型来说,你不仅可以自己训练,也可以通过互联网快捷方便地下载别人训练好的 LoRA 或模型。第三方社区的庞大,意味着你可以更加简单方便地入门 AI 绘画使用。

SD 是一种 潜在扩散模型(LDM),具备文生图与图生图能力,前者即通过一串提示词来让 AI 明白你想生成图像的细微特征。

SD 的优势:

- 高效性:可在消费级GPU(如8GB显存)上运行,推理速度较快(几秒至几十秒)。

- 开源生态:模型代码与权重公开,催生大量衍生工具(如WebUI、插件)和社区优化。

- 多样化应用:支持图像修复(inpainting)、扩展(outpainting)、风格迁移及超分辨率。

SD 的应用场景:

- 艺术创作:设计师快速可视化概念,生成插画、海报等。

- 教育科研:辅助解释抽象概念,如生物细胞结构或历史场景复原。

- 商业领域:广告原型设计、个性化商品图案生成。

SD 与其他模型相比较:

- DALL·E 3(OpenAI):闭源,与ChatGPT集成,提示理解更强。

- MidJourney:专注艺术性,输出更风格化,需订阅服务。

所以你能发现,SD 确实是一个免费又好用的工具。(更重要的是,本地部署出图没有任何内容审查限制,所以 NSFW 之类你懂的  )

)

本文目录

—运行机器要求介绍

——硬件要求

——软件环境

—部署 SD

—界面参数解释

——提示词(Prompt)

——采样方法

——迭代步数

——高分辨率修复

——分辨率设置、提示词引导系数、种子

—模型

——大模型

——LoRA

——VAE 模型

——模型下载

运行机器配置要求

硬件要求

SD 对显卡、CPU及内存都有一定要求。

这里仅代表个人观点,实际情况可能有些许差异。但请您确保您至少有一张独立显卡,这里直接说核显跑不了省事。显卡现在红蓝绿三家,我推荐绿厂(Nvdia),因为 Cuda 已经具备了完整的深度学习生态,性能也给的足(但是价格嘛......)

| 硬件 | 最低要求 | 推荐配置 |

| 显卡(GPU) | NVIDIA GPU(显存 ≥ 4GB) (如 GTX 1650、RTX 3050) | NVIDIA GPU(显存 ≥ 8GB) (如 RTX 3060、RTX 4090) |

| 内存(RAM) | ≥ 8GB | ≥ 16GB |

| 处理器(CPU) | 多核处理器(如 Intel i5 或 AMD Ryzen 5) | 高性能多核(如 Intel i7/Ryzen 7 及以上) |

| 存储 | ≥ 10GB 可用空间(模型文件约 2-8GB) | SSD 硬盘,预留 ≥ 20GB 空间 |

软件环境要求

其实软件环境不用发愁,因为本文使用秋叶aaaki大佬的整合包进行演示,环境打包好了。但如果您需要:

- 操作系统:Windows 10/11、Linux(Ubuntu 等)、macOS(需通过优化工具运行)。

- Python:3.7 及以上版本。

- CUDA:建议 11.x 版本(仅 NVIDIA GPU 需要)。

- 框架:PyTorch + 相关依赖库(如

diffusers、transformers)。

操作系统推荐 Win10/11,一是图形化,二是限制少。

若是本地没有合适配置的机器的,可以考虑云 GPU 服务器。这里也推荐雨云的宿迁云 GPU 服务器(Tesla P40 专业计算卡)。通过下方专属优惠通道注册(直接官网注册的可以注册时填写优惠码“hotaru”,直接点击下方链接则自动为优惠通道注册,目前该优惠码亲测有效)后,绑定微信领取专属五折券,点击购买 KVM,地区选择江苏宿迁,配置选择 Tesla Pascal 显卡云。4H8G+2G 显存配置仅需 64元 首月。

部署 SD

强烈推荐使用秋叶aaaki大佬的整合包!一键启动去除繁琐环境依赖的过程。这也是本文使用的方法。

SD 开源地址:Home · AUTOMATIC1111/stable-diffusion-webui Wiki · GitHub

秋叶aaaki大佬的 Bilibili 主页:秋葉aaaki的个人空间-秋葉aaaki个人主页-哔哩哔哩视频

出于对原作者的尊重,这里不提供下载地址。请各位去上方大佬主页寻找整合包视频下载。

下载完成后,解压整合包文件到任何一个目录(总不能不会解压吧?)

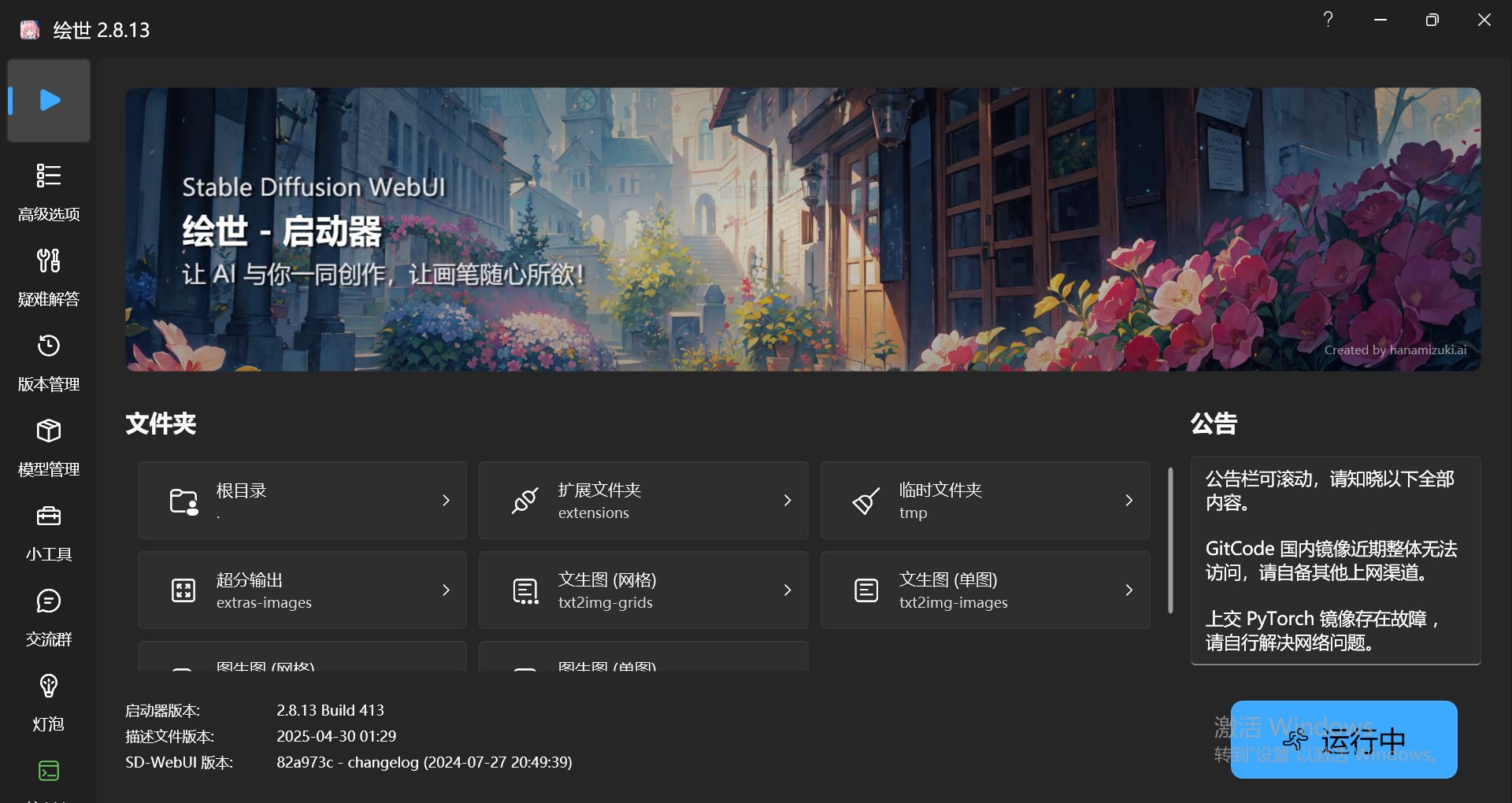

解压完成后,请进入整合包根目录,找到 A绘世启动器.exe,双击运行,你会看到如下界面:

点击“一键启动”按钮,变为“运行中”,耐心等待一段时间后,会自动跳转浏览器并访问(默认端口 7860) http://127.0.0.1:7860/?__theme=dark,若未自动访问,也可以手动访问。需要亮色主题的,可以访问 http://127.0.0.1:7860/?__theme=light,即可切换为亮色主题。

注意!若您遇到浏览器点击操作后程序无反应的情况,请尝试不要使用 Edge!

如果你顺利进入了 Web UI,那么恭喜你,你可以继续了。

界面参数解释

可能到这里您就要疑惑了:这么多奇葩的词语我怎么可能认识啊喂!不过不用太过担心,对于实在不懂或难以理解的参数,我们只需保持默认即可。

第一栏:

- 文生图:根据文本提示生成图像

- 图生图:根据基本图像生成新图像

- 模型合并:把已有的模型按不同比例进行合并生成新模型

- 训练:根据提供的图片训练具有某种图像风格的模型

(反向)提示词

文生图选项卡中,你会看见“提示词(Prompt)”与“反向提示词(Negative prompt)”

提示词就是你想让 AI 遵循的画法,而反向提示词就是你不希望画面中出现的事物。

示例:

- 提示词:highres,masterpiece, best quality, masterpiece,highres,best quality,8k,......

- 反向提示词:(low quality,worse quality:1.2),bad-hands-5, bad-artist, lowres, bad anatomy, bad hands, text, error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, username, blurry, artist name,......

Tag(提示词)可以直接在 C站(Civitai)或是别的 AI 作品分享网站上照抄你喜欢的。

Tag 可以指定权重,同时越靠前的 Tag 权重越高(SD 优先遵循前面的提示词)。

这里简单提及一下修改提示词权重的方法,由于本教程并不是专门服务于提示词的,所以如果您需要更详细的知识,可以移步至别的提示此教程类文章。

通过括号修改权重:

- (tag) —— 将权重提高 1.1 倍

- ((tag)) —— 将权重提高 1.21 倍(= 1.1 * 1.1)

- [tag] —— 将权重降低至原先的 90.91%

- (tag:1.5) —— 将权重提高 1.5 倍

- (tag:0.25) —— 将权重减少为原先的 25%

采样方法

再往下的“生成”选项卡中,您会首先看到“采样方法”

采样方法多样,建议您不断尝试直到找到适合您正需要的图的采样方法,或者您也可以直接保持默认。

迭代步数

即不能太低也不能太高。程序默认是20步。对于这个参数你可以简单理解为一张图总共需要画的次数。

步数越多出一张图越慢,反之则越快。步数越多出图质量更高,反之则低(注意,过高的步数对图像质量没有任何帮助!)

推荐设置为 20-40,我一般测试时 15 步,开始正式跑图时 30 步,可以视自己的硬件情况、时间充裕程度或是目标图像而定。

如果 30 步仍不能帮你画出你想要看到的细节,可以继续调高至 40 甚至 40+。

高分辨率修复 (Hires. fix)

这个选项嘛就很好理解了,高分辨率修复。启用这个选项后,SD 画的便不是你输入的宽度与高度了,而是会依据设置的放大倍数(默认为两倍)来画一张更高分辨率的图随后输出为低分辨率。这样做的好处是出图质量更高,坏处是出图时间可能直接翻倍。

其实可以偏门地理解为 MS 那类抗锯齿(如 MSAA)。

放大倍数

上方提到过了,指 SD 将生成多少倍于宽高设置的图像。

重绘幅度

算法对图像内容的保留程度。数值越高则放大后图像与原图差距越大,数值越低则反之。若开启了高分辨率修复,建议默认 0.7 不用管它即可。

宽高度

其实就是最终输出图片的分辨率,这很好理解。

这里推荐一些分辨率:

- 方块:512*512 或 768*768.

- 人物(竖):512*768

- 横:768*512

尽管您可能会疑惑:为什么不能直接输出 1920*1080 之类的低分辨率图像呢?其实这是因为大分辨率图像可能会造成一些问题:例如画面元素杂糅、次品率提高、一张画面总是出现多个人物等。如果您实在需要输出这类大图,请使用更大的模型(同时对显存的要求也会更高)。

提示词引导系数 (CFG Scale)

默认是7,这在创造力和生成你想要的东西之间提供了最佳平衡。通常不建议低于5。

CFG量表可以分为不同的范围,每个范围都适合不同的提示类型和目标:

- CFG 2~6:有创意,但可能太扭曲,没有遵循提示。对于简短的提示来说,可以很有趣和有用。

- CFG 7~10:推荐用于大多数提示。创造力和引导一代之间的良好平衡。

- CFG 10~15:当您确定您的提示是详细且非常清晰的,您希望图像是什么样子时。

- CFG 16~20:除非提示非常详细,否则通常不推荐。可能影响一致性和质量。

- CFG >20:几乎无法使用。

随机数种子 (Seed)

一般不用指定。

如果您玩过 Minecraft 或 Terraria 等沙盒游戏,也可以把这两者视为相同作用的东西:决定生成结果的特征。

模型

模型介绍

你有很大概率是想来给自己喜欢的游戏/动漫角色生成图片,或者是其他用途,但您绝对离不开模型。

模型其实就是通过特定的数据训练,根据训练数据的不同,不同模型生成的数据也不同。(例如训练时涩图喂多了就只会画涩图了)

模型分为全量模型与 LoRA(微调模型训练),一般推荐后者,因为后者体积小(一般仅为几百 MB,与单个模型 2GB+ 对比确实很小),而且效果也不差。

大模型(Checkpoint)

简称 CPT,是相较于 LoRA 更加底层的模型,直接决定图片生成风格。

下载 CPT 后放入 SD 根目录的 /models/Stable-diffusion

LoRA(微调模型)

在 CPT 的基础上使用。可以决定图片生成的风格。

下载后放入 SD 根目录内的 /models/Lora

刷新后可以在 Prompt 中通过 <lora:LORANAME:1> 为示例调用,解释如下:

- lora:指定要调用的 LoRA。

- LORANAME:要调用的 LoRA 的名字。

- 1:权重,可以自行调整,但不推荐超过 1.2。

您也可以叠加多个 LoRA,例如将不同类型的 LoRA 一起调用并配合权重调整以生成更加符合您预期的图片。

外挂 VAE 模型

VAE 模型能让您的作品色彩更加鲜艳。如果不懂可以直接选择 vae-ft-mse-840000-ema-pruned.safetensors。

下载后放入 SD 根目录内的 /models/VAE

下载模型

对于模型的获取,有网上下载与自己训练两个方法。由于本篇教程只涉及推理绘图而不涉及训练,所以这里推荐几个模型下载网站:(有些可能需要神秘东方魔法才能打开)

例如 C站(Civitai)。下载后放入上面提到过的目录后刷新模型列表即可使用。

供参考的页面

Stable Diffusion超详细教程!从0-1入门到进阶 - 知乎

GitHub - AUTOMATIC1111/stable-diffusion-webui: Stable Diffusion web UI

Comments 2 条评论

oh,yes sir♂

@1465801348@qq.com 主播我喜欢你